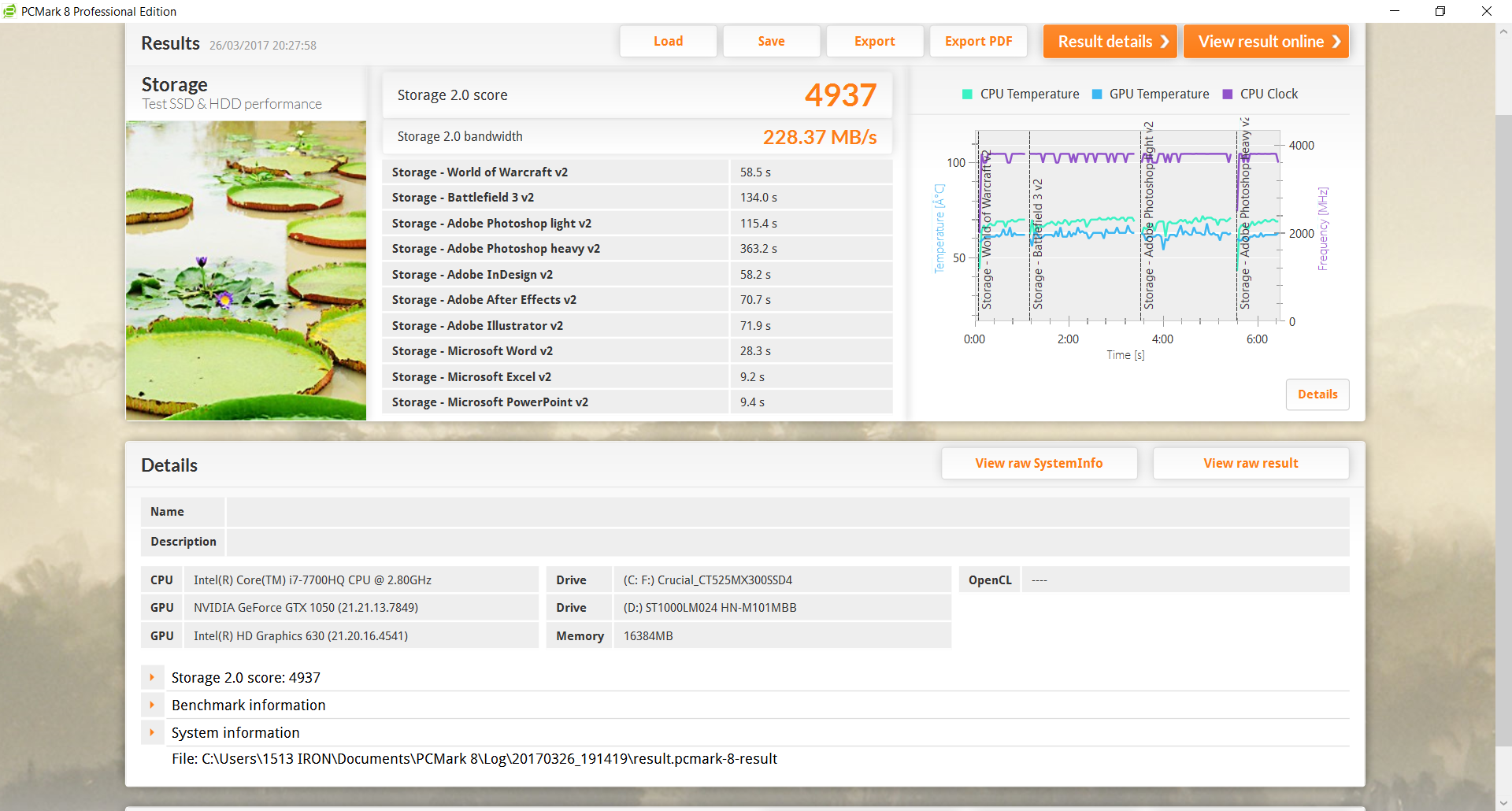

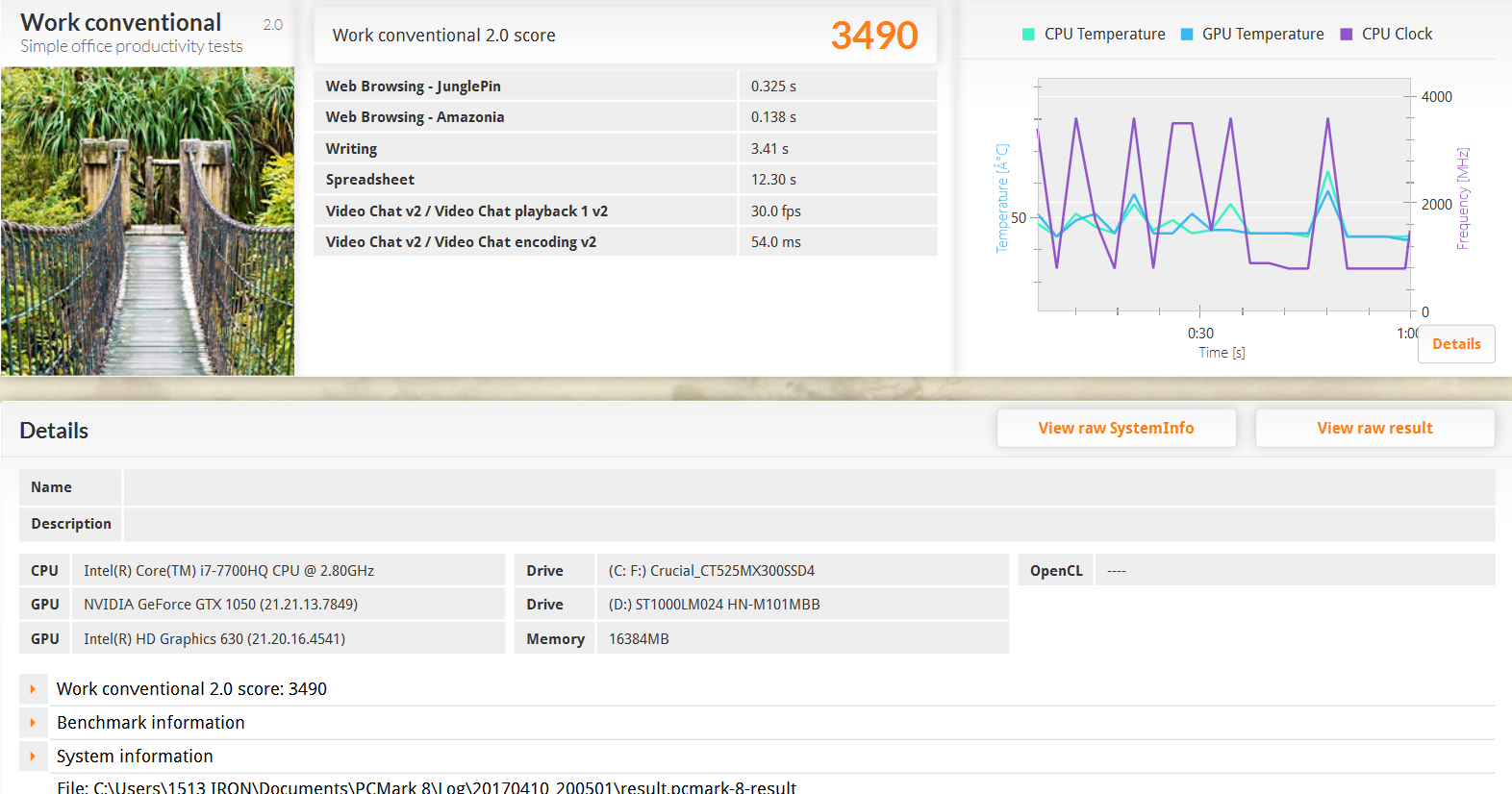

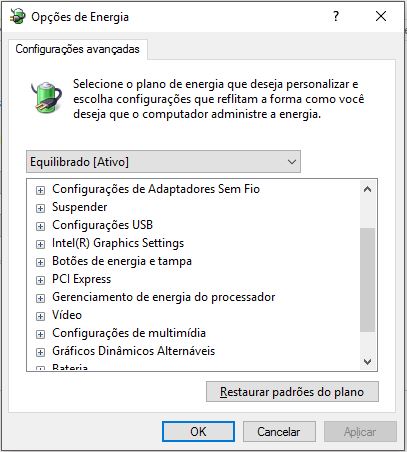

Programas de benchmarks de GPU são excelentes ferramentas para medir o potencial de um notebook. Além de, claro, verificar a integridade dos componentes, em especial a estabilidade de possíveis overclocks. Por fim, conseguem mostrar possíveis gargalos no sistema, de lentidão excessiva de um componente específico até uma temperatura de trabalho perigosa. Ou seja, vão além de mostrar o poder de fogo bruto do sistema, e hoje vamos entender como eles funcionam na medição do potencial gráfico da máquina.

Conhecendo sua GPU

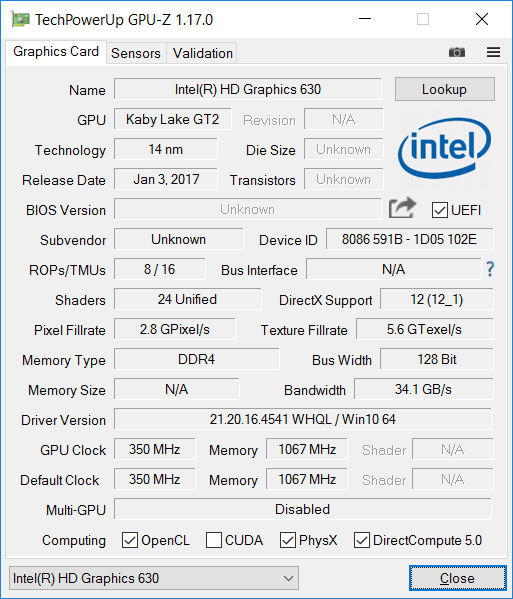

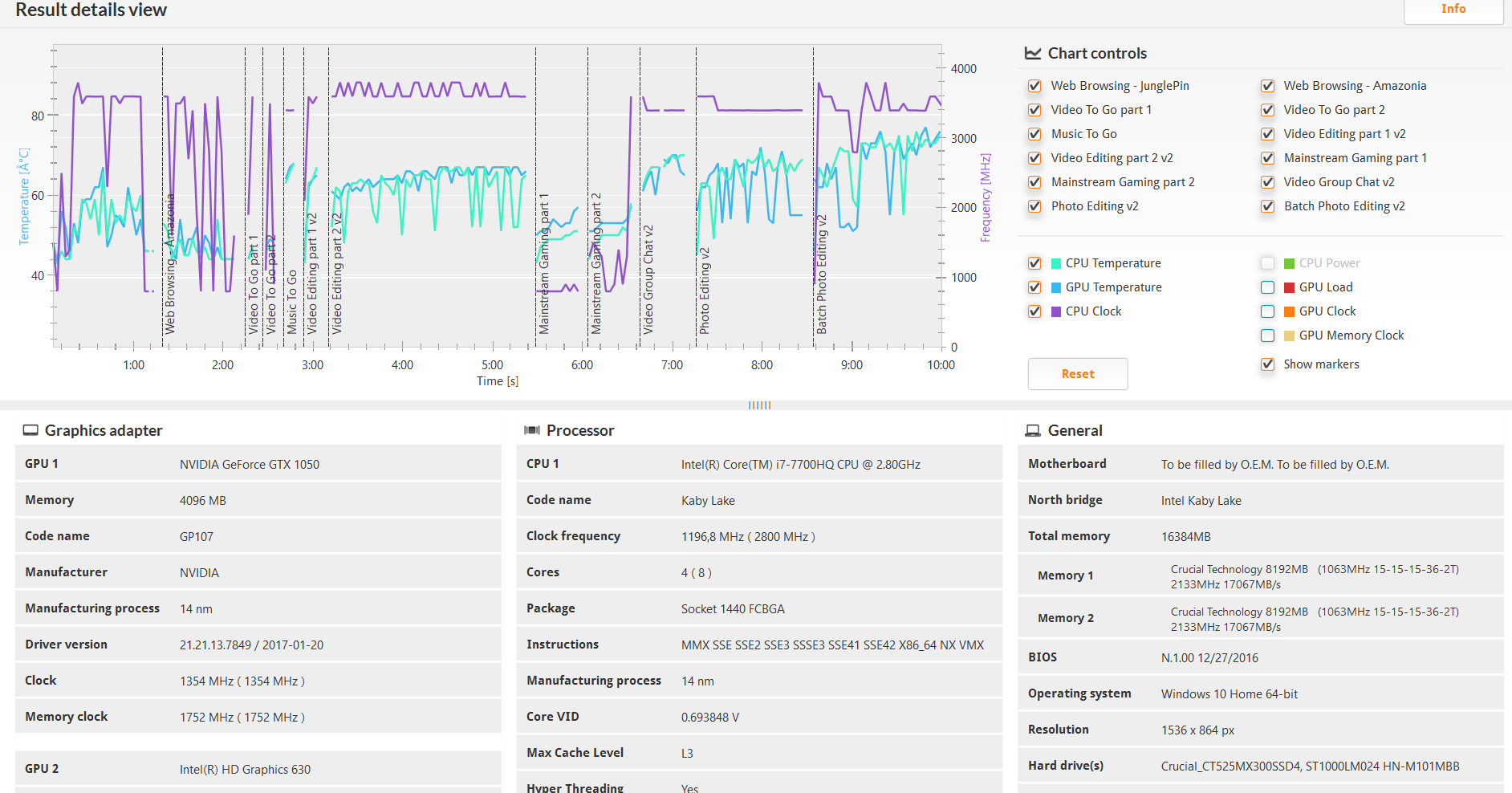

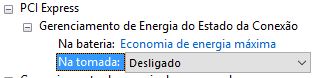

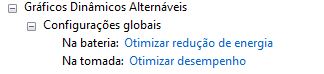

Grande parte dos notebooks que trazem GPUs de alto desempenho também conta com gráficos integrados, que “mandam” no display. Ainda que estas não sejam tão fracas como há alguns anos, estão longe de oferecer o desempenho de uma placa de vídeo dedicada. Mas cumprem um papel importante: preservar bateria quando não há necessidade de tanto desempenho e manter o computador frio em tarefas cotidianas, como navegar na internet e editar textos. No caso do Avell Titanium G1513 IRON V4 que temos em mãos, temos uma Intel HD 630:

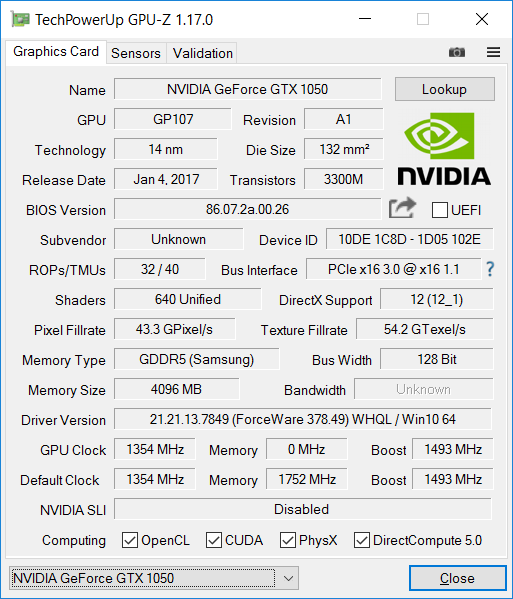

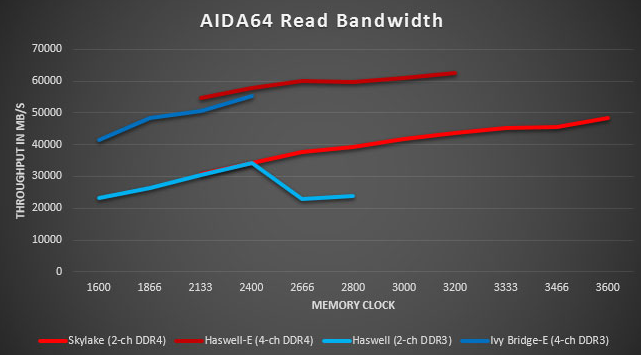

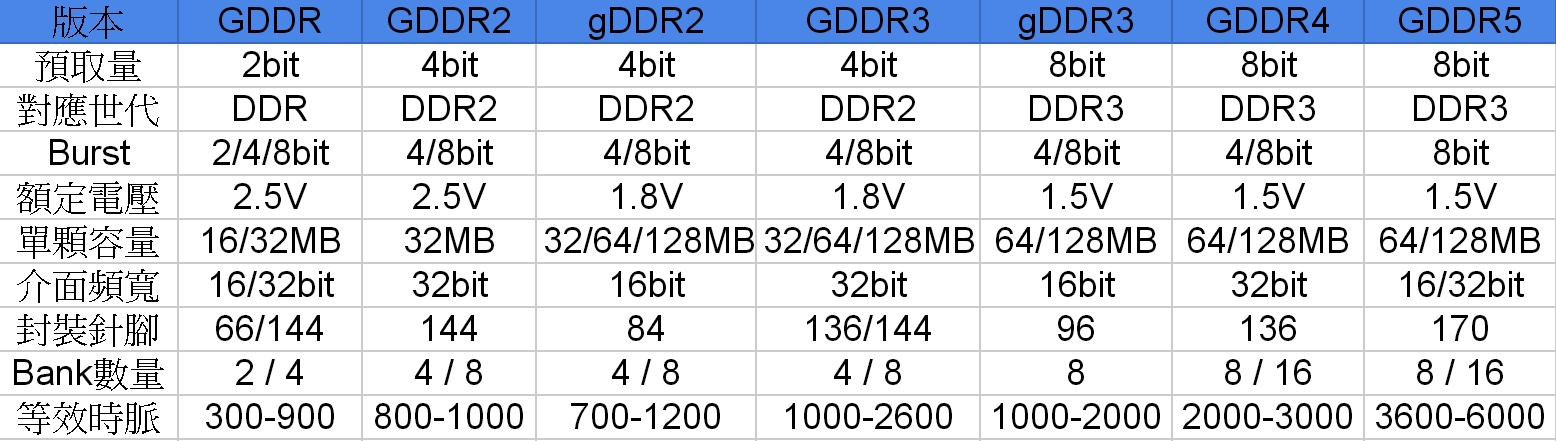

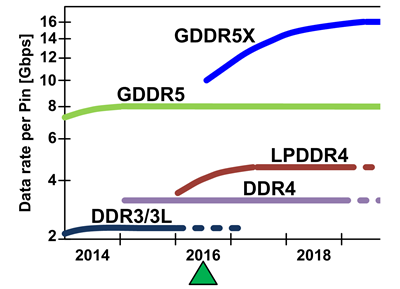

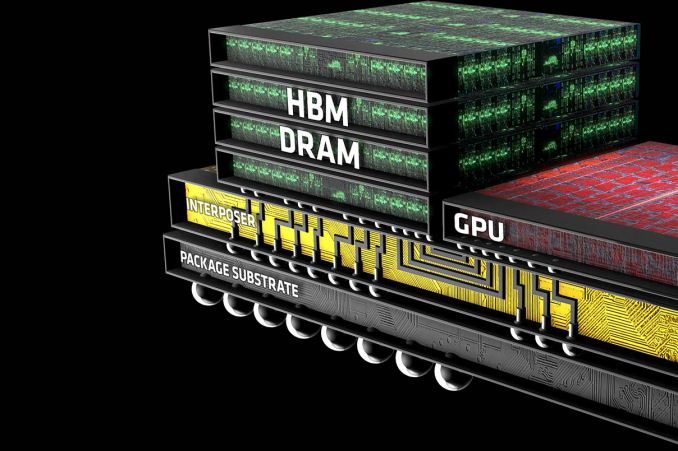

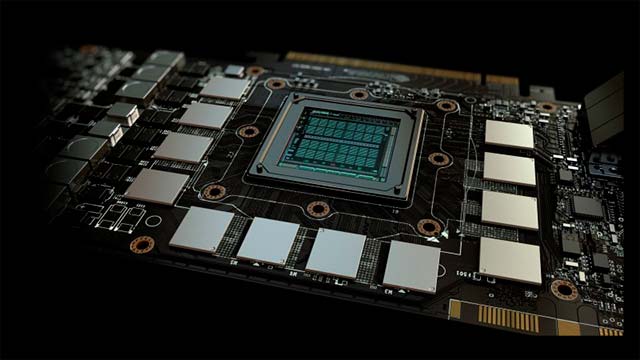

Por ser integrada ao processador, a Intel HD 630 compartilha a memória RAM do sistema. No caso, parte dos 16 GB DDR4 rodando a 2133 MHz. Possui 24 shaders com frequência máxima de 1150 MHz. Pouco, não? Sim, pois a estrela do show aqui é a NVIDIA GeForce GTX 1050, que entra em ação automaticamente na hora de rodar um jogo mais exigente:

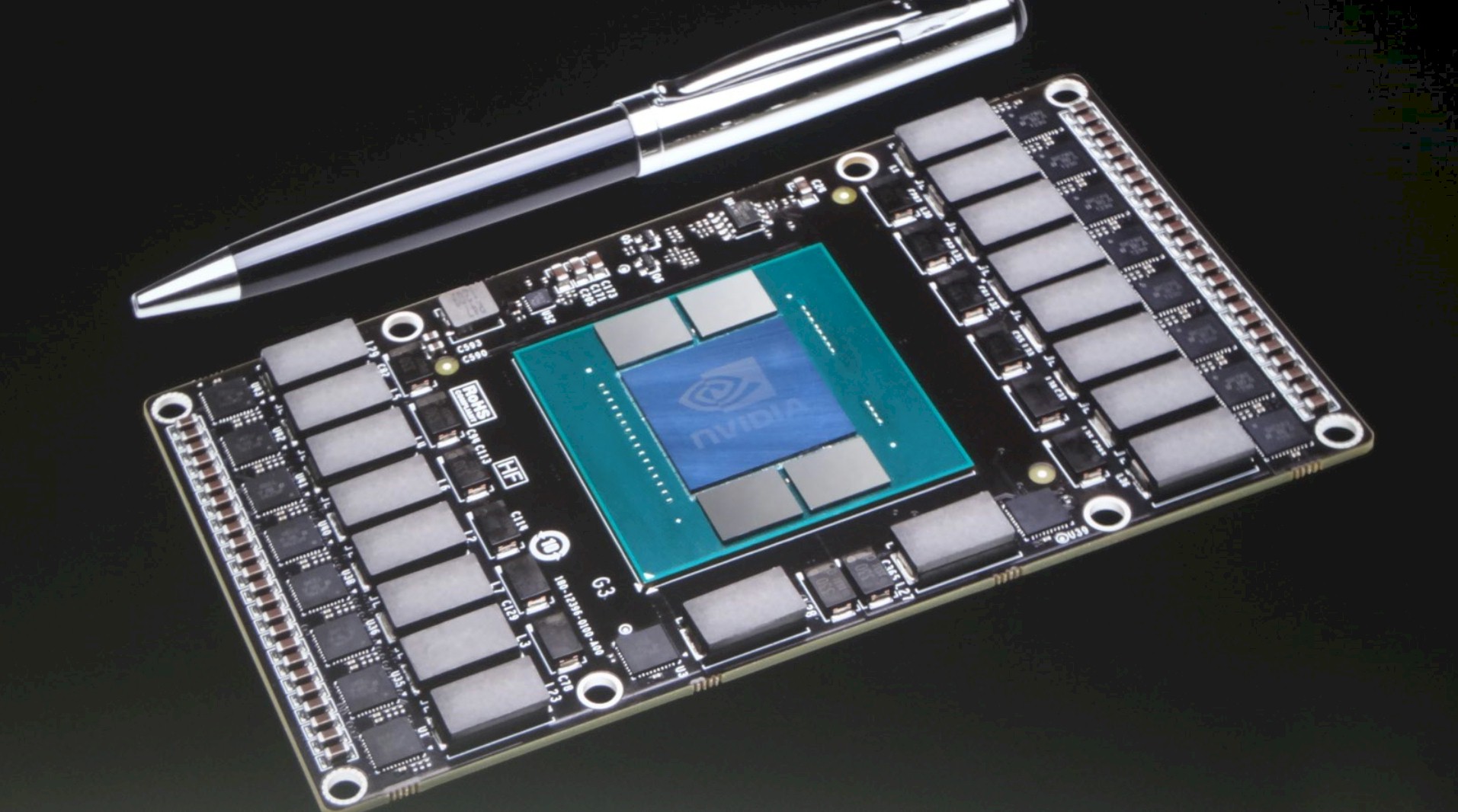

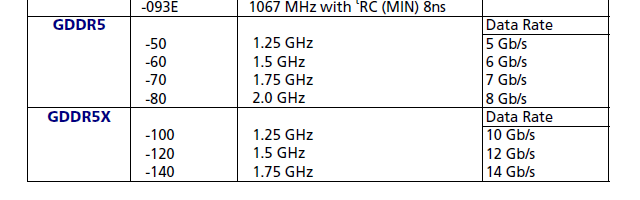

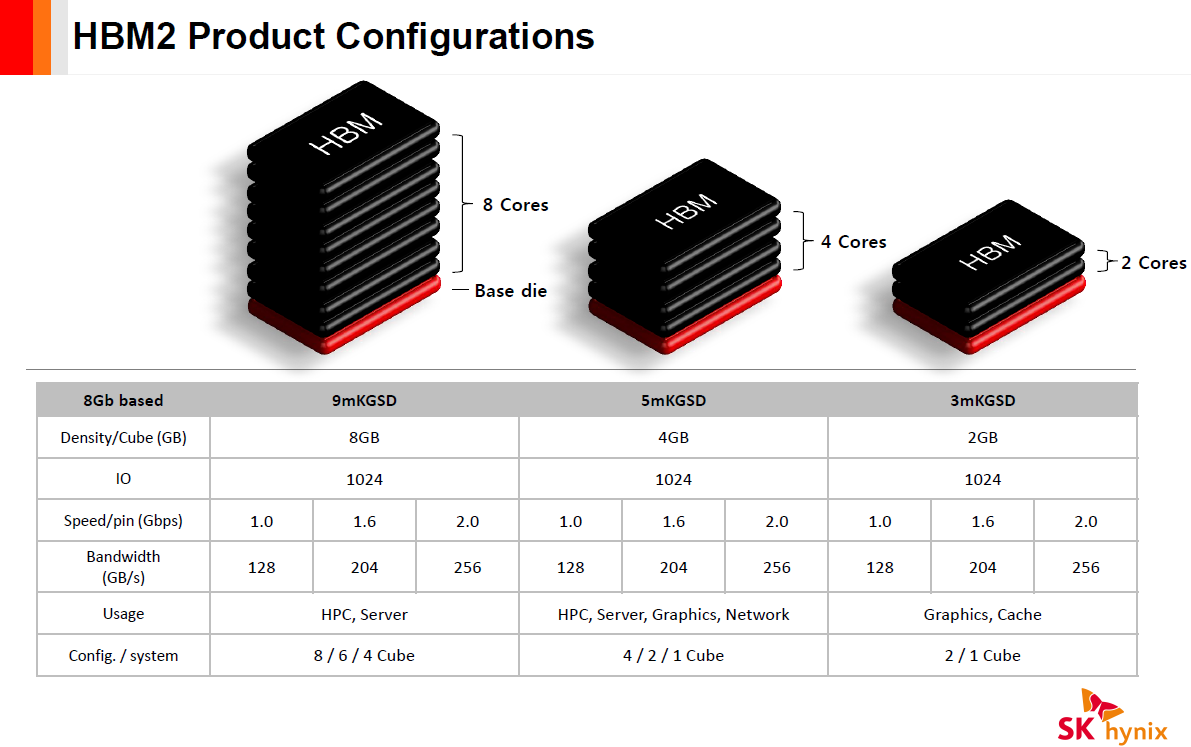

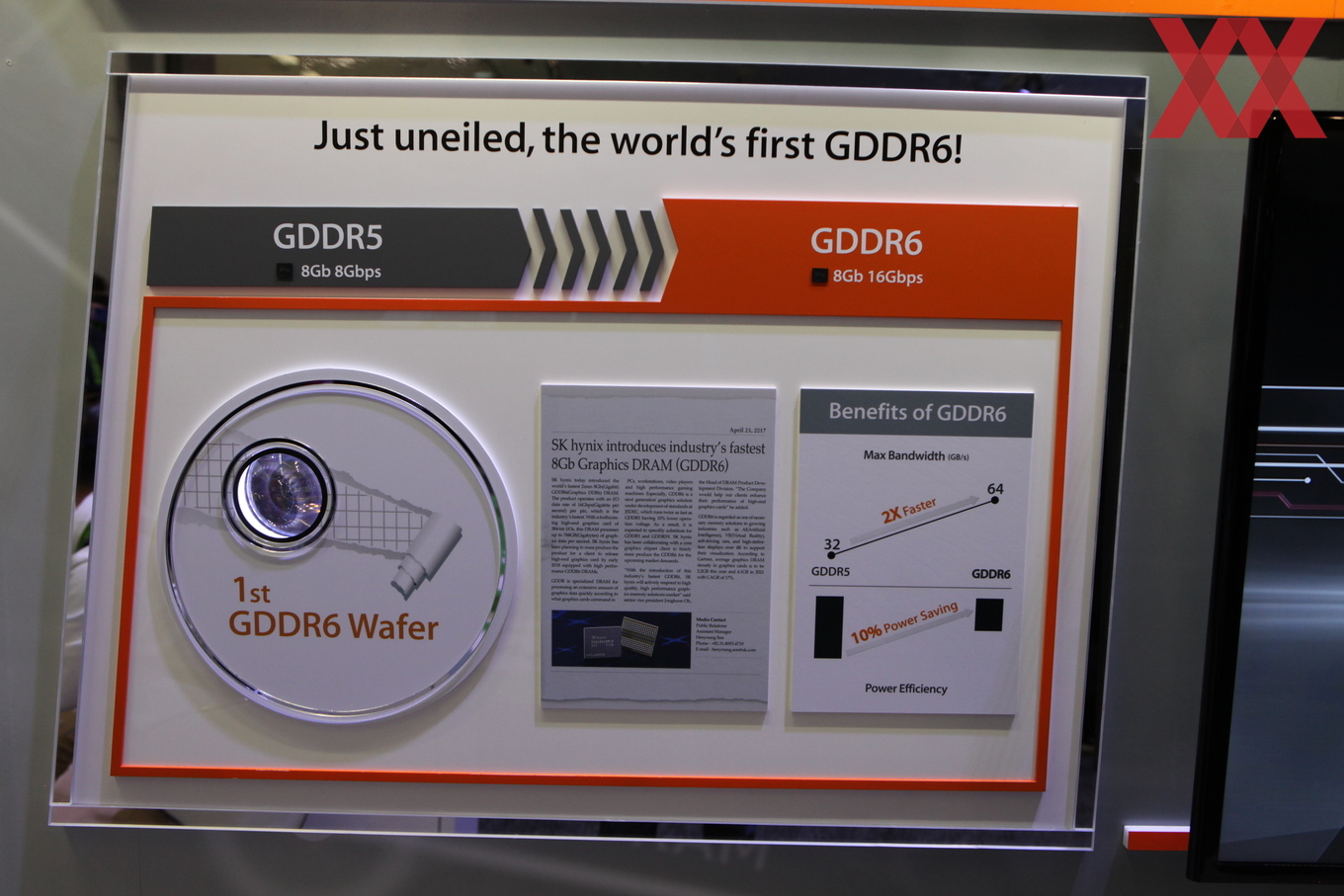

Assim como acontece com os chips mais potentes da NVIDIA, não há diferenciação entre desktop e notebook na GTX 1050, o mesmo valendo para a GTX 1050 Ti. Mesmo sendo a GPU mais básica da série 10 da NVIDIA, as diferenças são gritantes: 640 shaders rodando a 1354 MHz, alcançando 1493 em modo Boost. Além disso, tem 4 GB de memória GDDR5 dedicada, rodando a 3504 MHz. Os dados mostrados já são um bom ponto de partida para comparar GPUs de uma mesma geração, mas vamos qual é o potencial dessa GPU na prática.

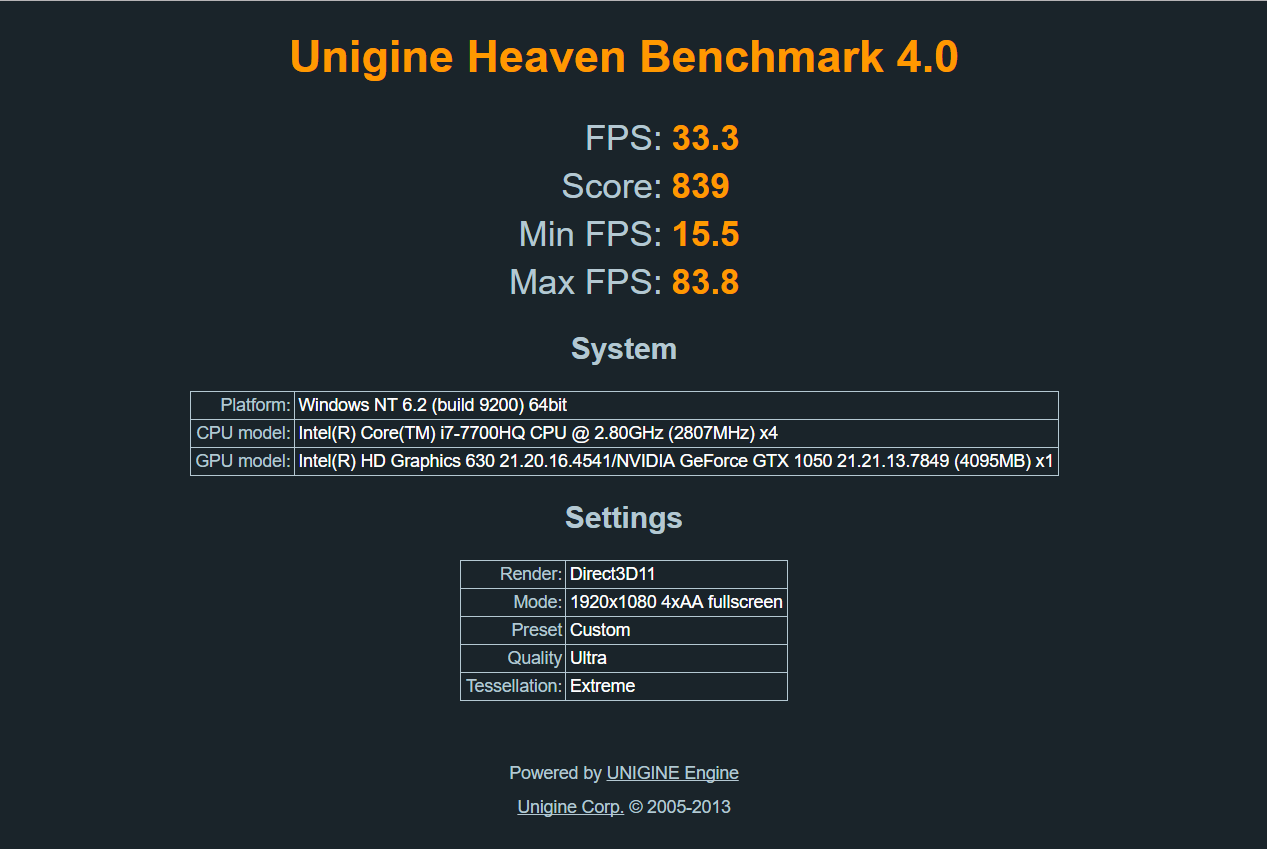

UNIGINE Heaven

Baseado na versão mais atual da UNIGINE Engine (versão 4.0, no caso), o Heaven coloca a GPU para trabalhar em renderizações muito próximas das presentes em games. Basta escolher a resolução e ajustar alguns filtros e efeitos para observar a capacidade da placa de vídeo em renderizar diferentes cenários. De forma gratuita, é possível medir o desempenho não somente da resolução esperada em si, mas também de iluminação, movimentação de diversos objetos e tesselation em DirectX 9, DirectX 11 e OpenGL 4.0.

Testamos a GTX 1050 em Full HD (1920 x 1080, resolução nativa do Titanium G1513 IRON V4) no modo Ultra, tesselation no Extreme e 4x AA. O resultado foi um FPS médio de 33,3 (máximo de 83,8) e temperaturas máximas de 70 ºC, sem um problema de estabilidade sequer.

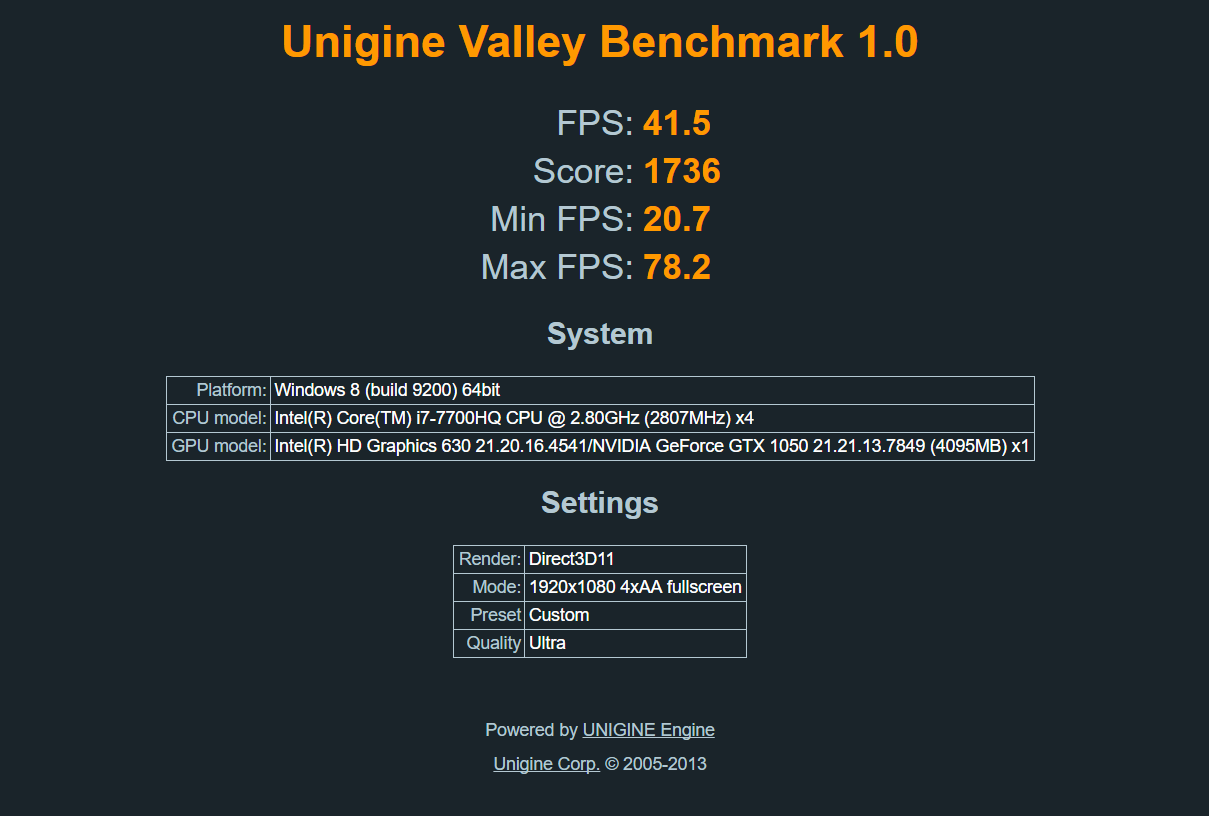

UNIGINE Valley

Também projetado pela UNIGINE, o Valley é tão customizável quanto o Heaven, mas trabalha com cenários diferentes. No caso, paisagens maiores e uma enorme quantidade de objetos em movimento de forma simultânea (grama, em especial). Usando os mesmos presets do Heaven (Full HD no modo Ultra, tesselation no Extreme e 4x AA), alcançamos um FPS médio de 41,5 frames por segundo (máximo de 78,2), também sem passar dos 71 ºC.

De forma igualmente importante, não observamos nenhuma instabilidade do sistema. Mais do que medir a capacidade da GPU de renderizar as cenas, tanto o Valley quanto o Heaven testam a robustez dos componentes. Máquinas com sistemas de refrigeração mais sofisticados se destacam aqui, sendo capazes de trabalhar sob condições pesadas por longos períodos sem alcançar níveis perigosos de temperatura.

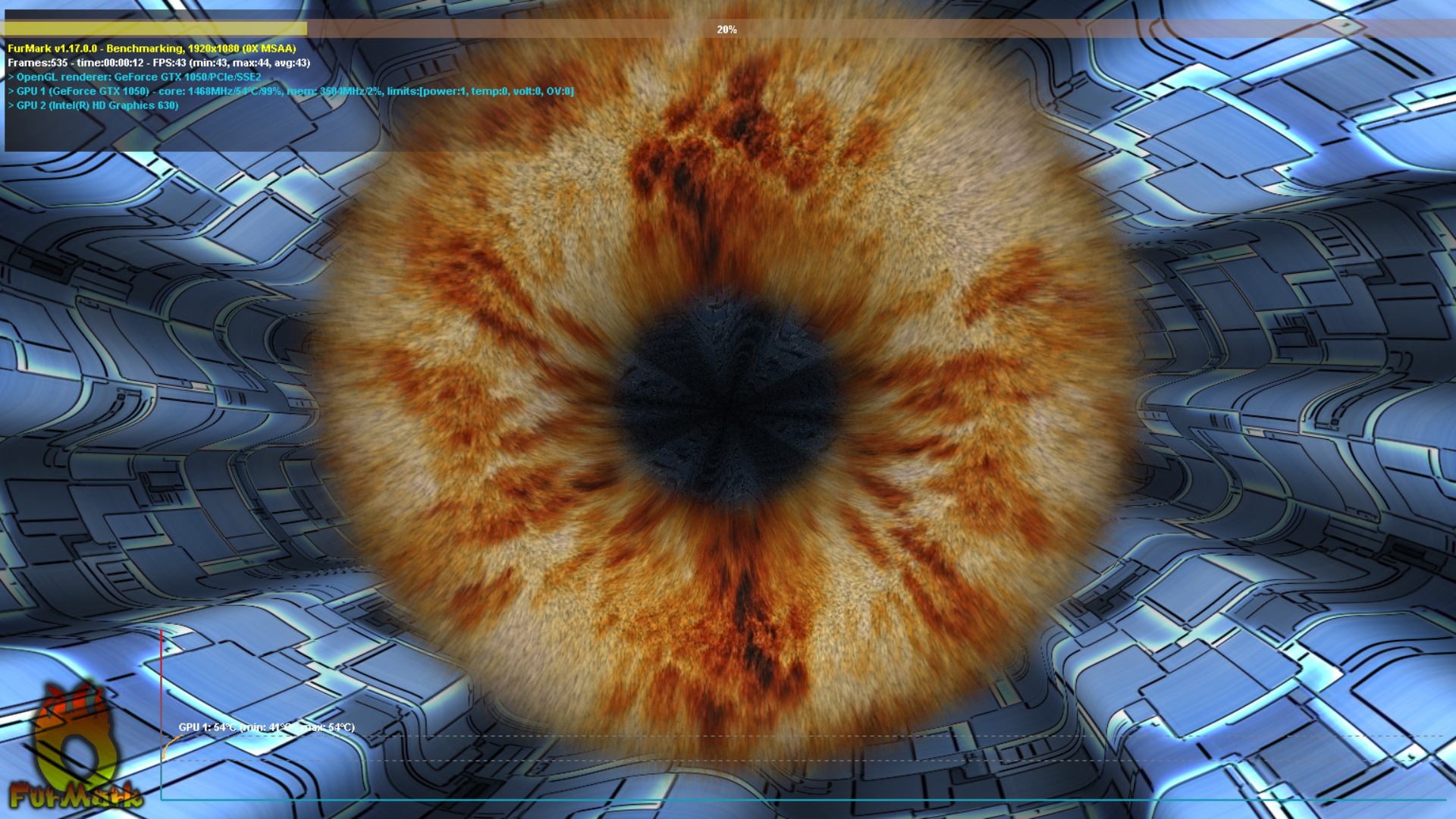

FurMark

Os dois testes acima possuem ferramentas próprias de análise de estabilidade. Porém, trabalham focando em renderizar uma cena em especial e medir o desempenho da máquina – de quebra analisando a integridade dos componentes. O FurMark faz o caminho inverso. O objetivo aqui é medir a estabilidade de forma primária, sem se preocupar tanto com a quantidade de frames por segundo que a GPU pode gerar, ainda que seja monitorado.

- CINEBENCH R15 OpenGL – GPU Test

Como isso acontece com uma “rosquinha peluda em movimento”? Cada um dos “pelos” é renderizado de forma independente, o que é um trabalho e tanto para a placa de vídeo. Um cenário praticamente inexistente em jogos reais, mas este não é o foco, e sim colocar a máquina para funcionar sob condições verdadeiramente estressantes. O motivo? Colocar a integridade dos componentes e testar o sistema de refrigeração em condições extremas.

Em especial, medir se o sistema de refrigeração é capaz e manter a GPU segura por longos períodos, situação típica de um game mais atual. Basta deixar o FurMark rodando por algum tempo. Se a máquina permanecer estável durante o teste, dificilmente apresentará instabilidades em qualquer situação, semelhante ao que acontece com programas como o OCCT.

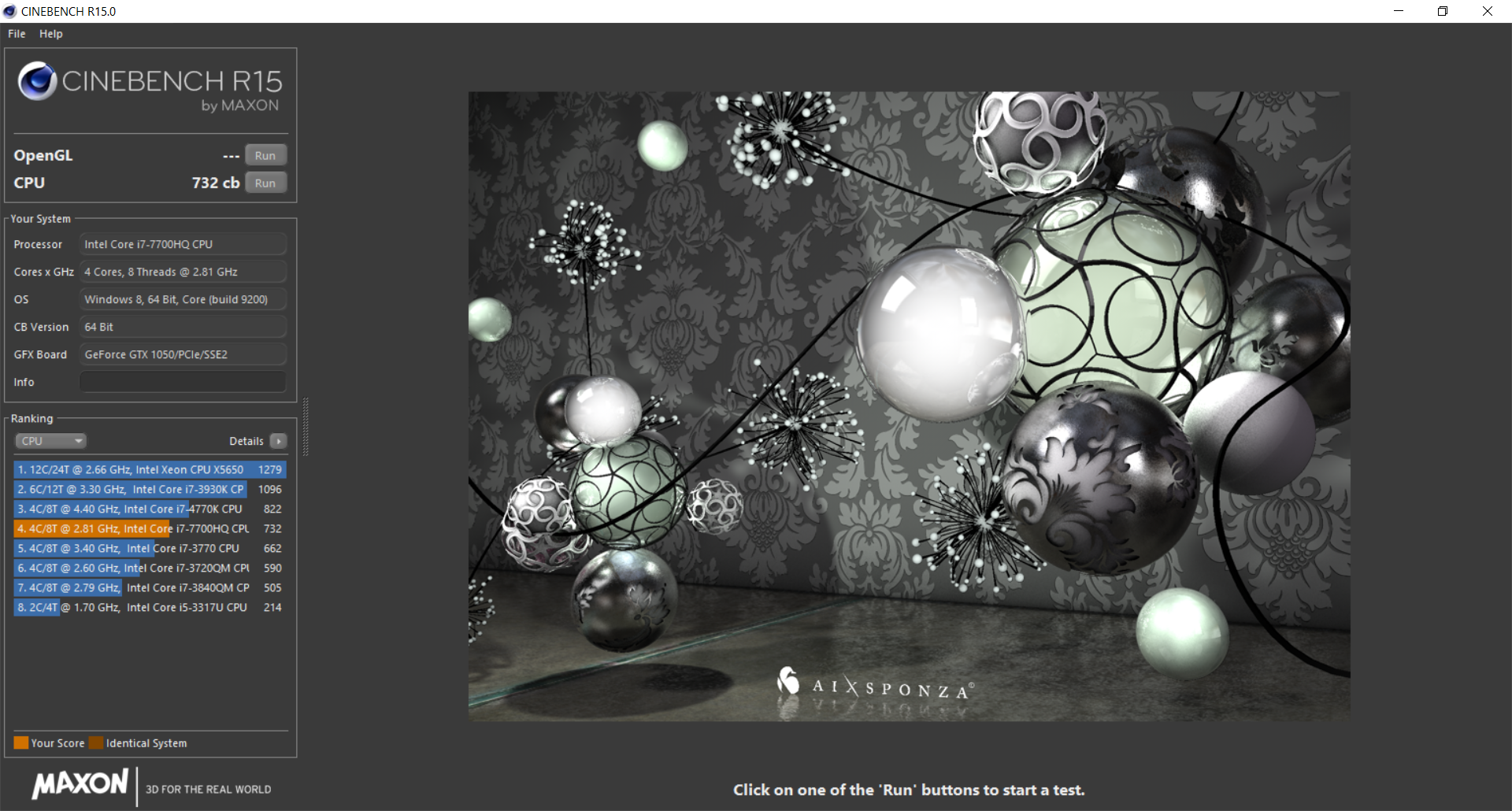

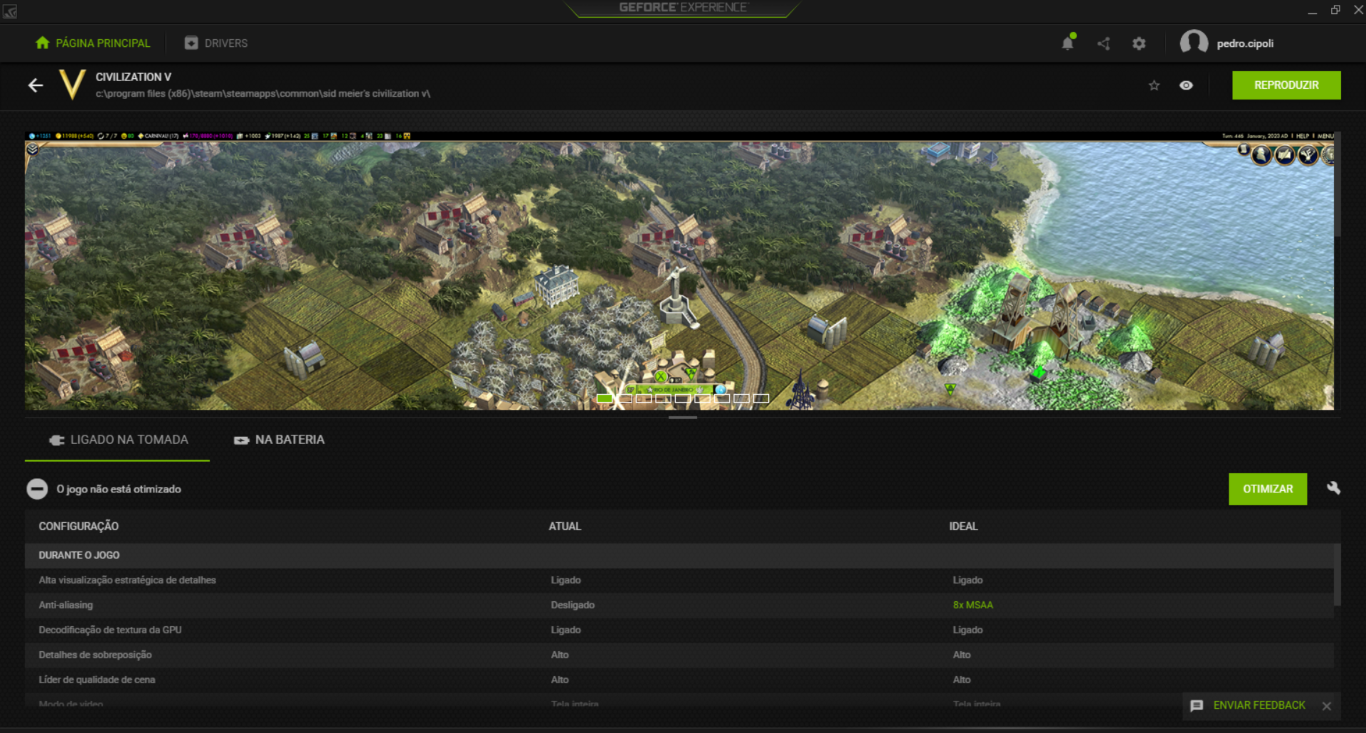

CINEBENCH R15 (OpenGL)

Diferentemente dos programas de benchmark da UNIGINE, o CINEBENCH avalia o comportamento da máquina em programas profissionais de criação. No caso do teste de GPU, uma perseguição de carros é renderizada em OpenGL usando mais de um milhão de polígonos. Mais do que isso, com efeitos de iluminação, transparência e cenas diferentes são utilizadas para medir a capacidade da placa de vídeo.

O resultado é exibido em quantidade de frames por segundo: quanto maior o número, mais poderosa é a GPU. Com o passar do tempo, é interessante continuar a rodar testes no CINEBENCH, mesmo que o hardware seja o mesmo. Conforme os drivers são atualizados, é possível analisar os ganhos de performance da máquina, já que otimizações ocorrem com frequência por parte da NVIDIA, assim como possíveis bugs são corrigidos.

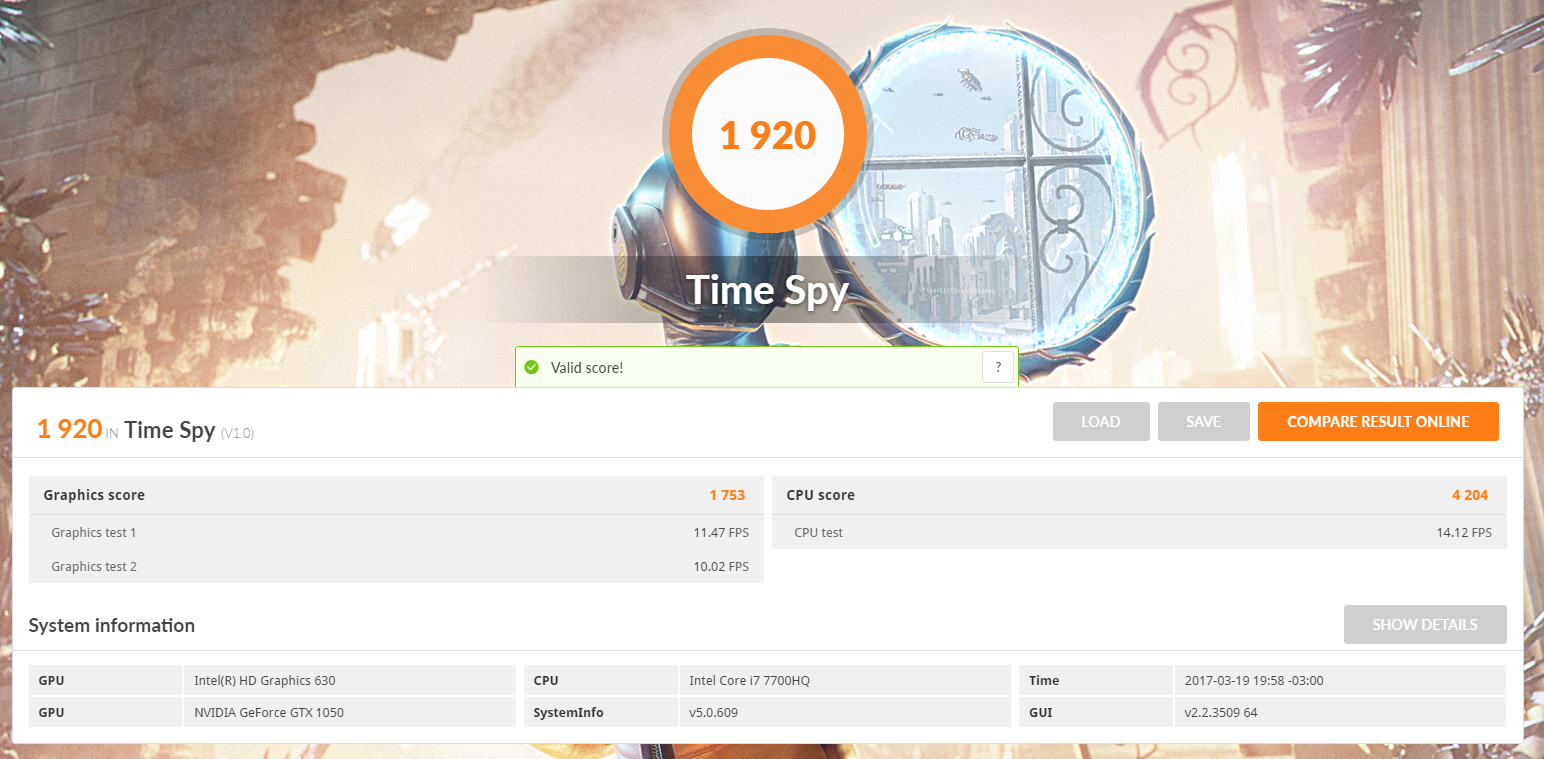

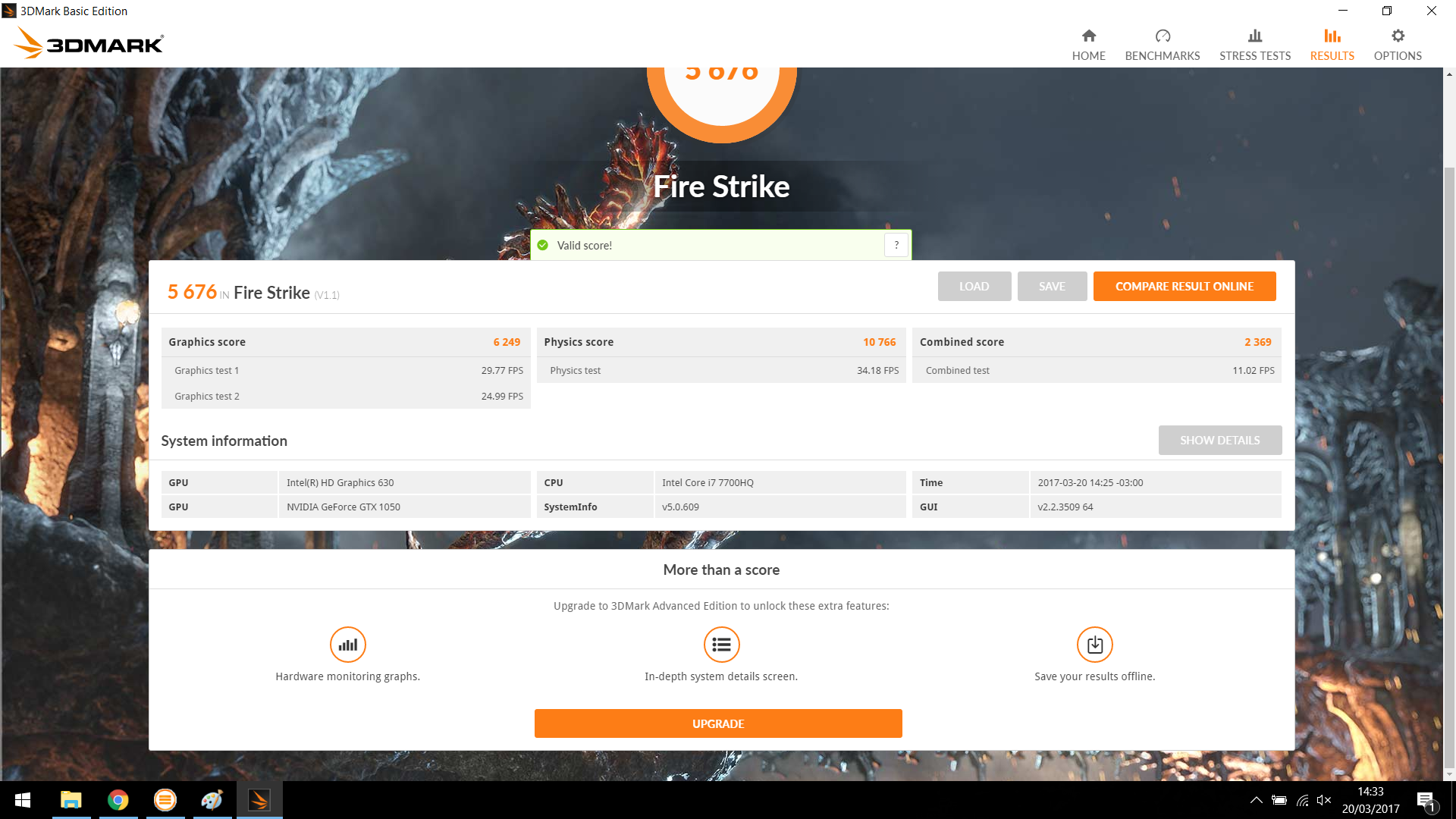

Conclusão sobre benchmarks

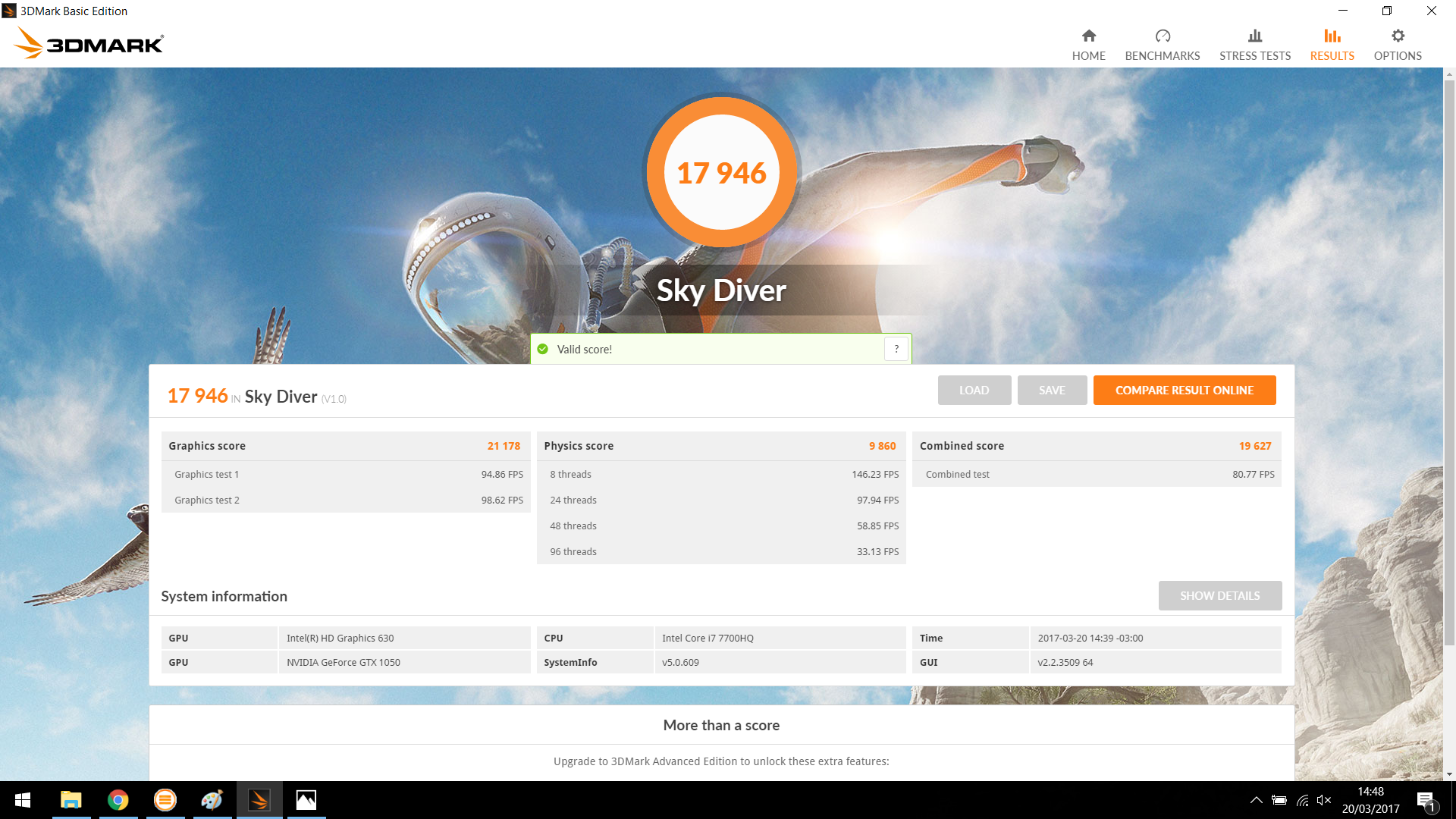

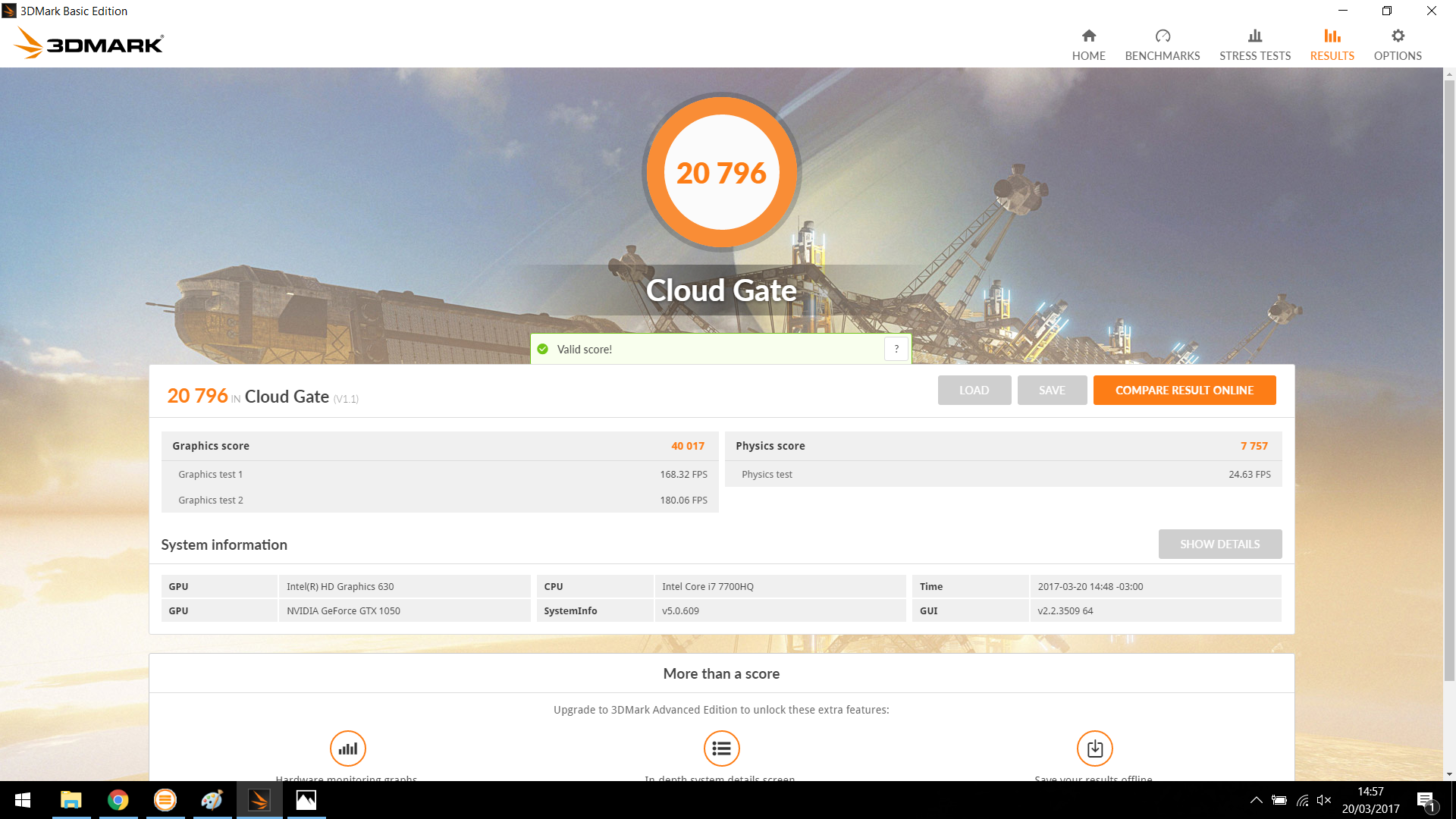

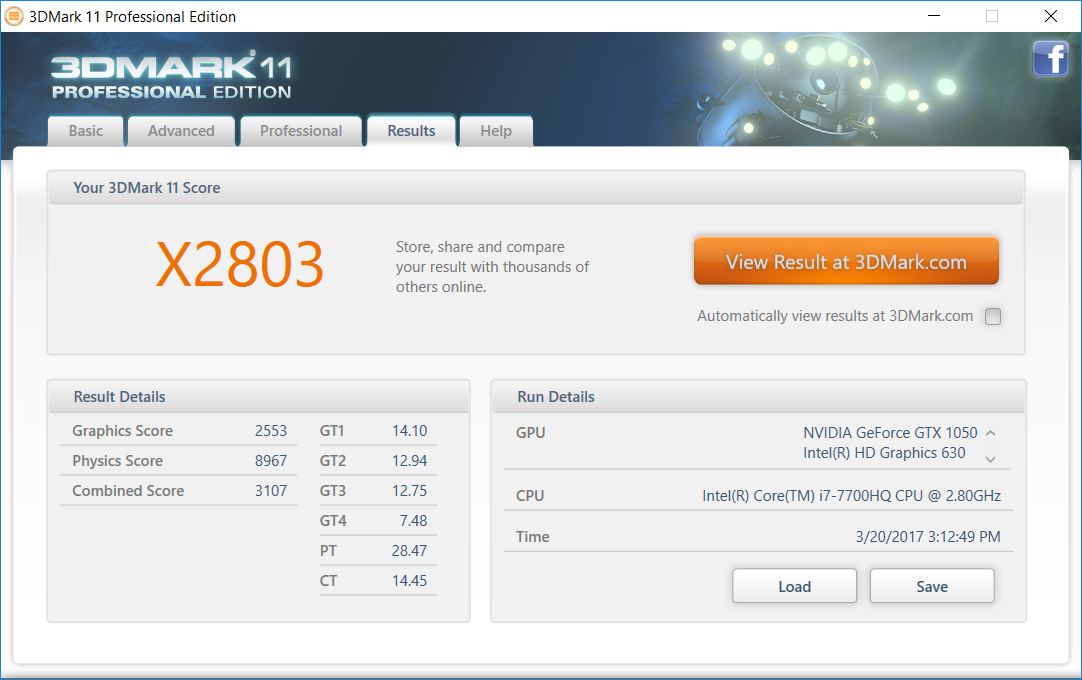

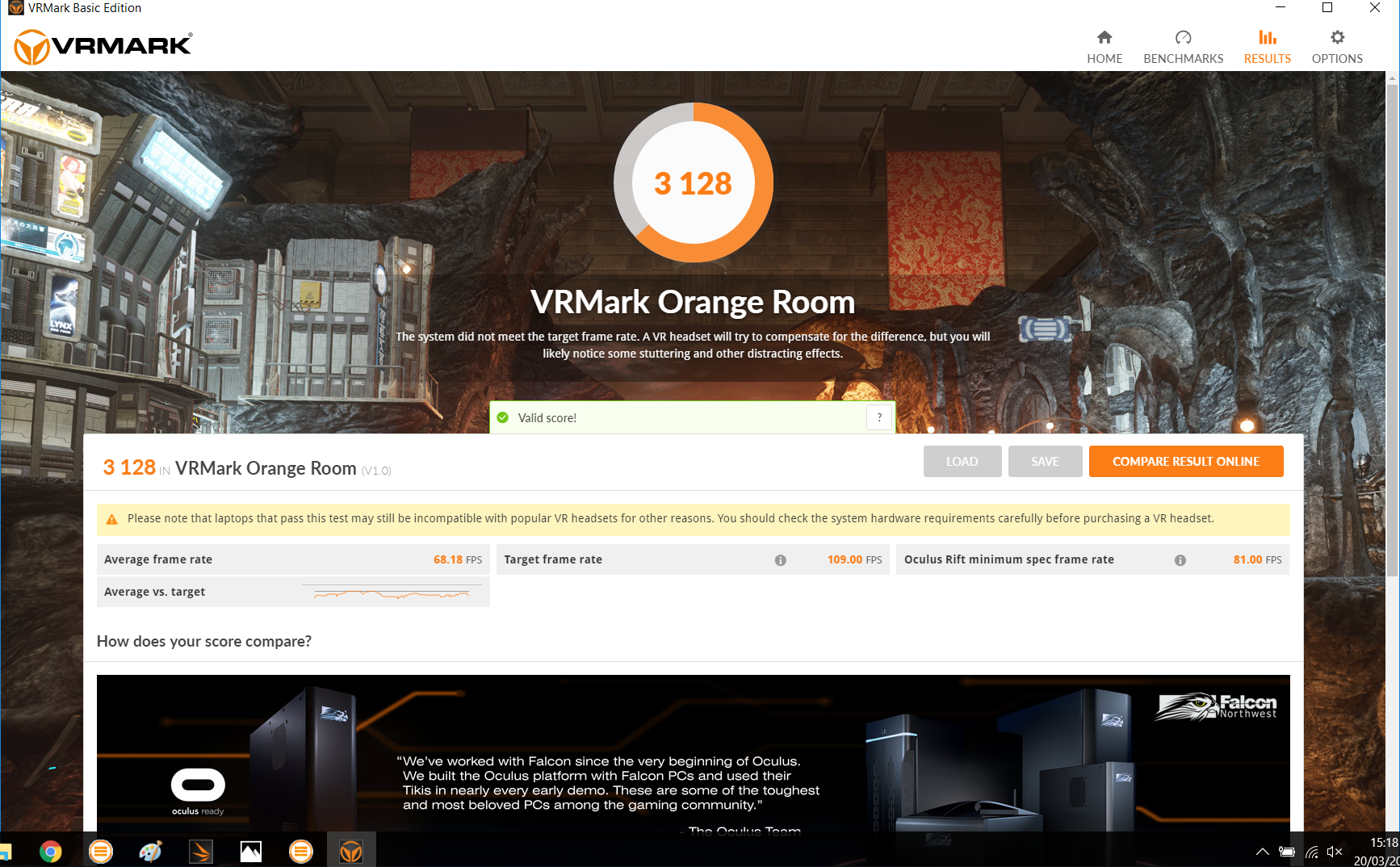

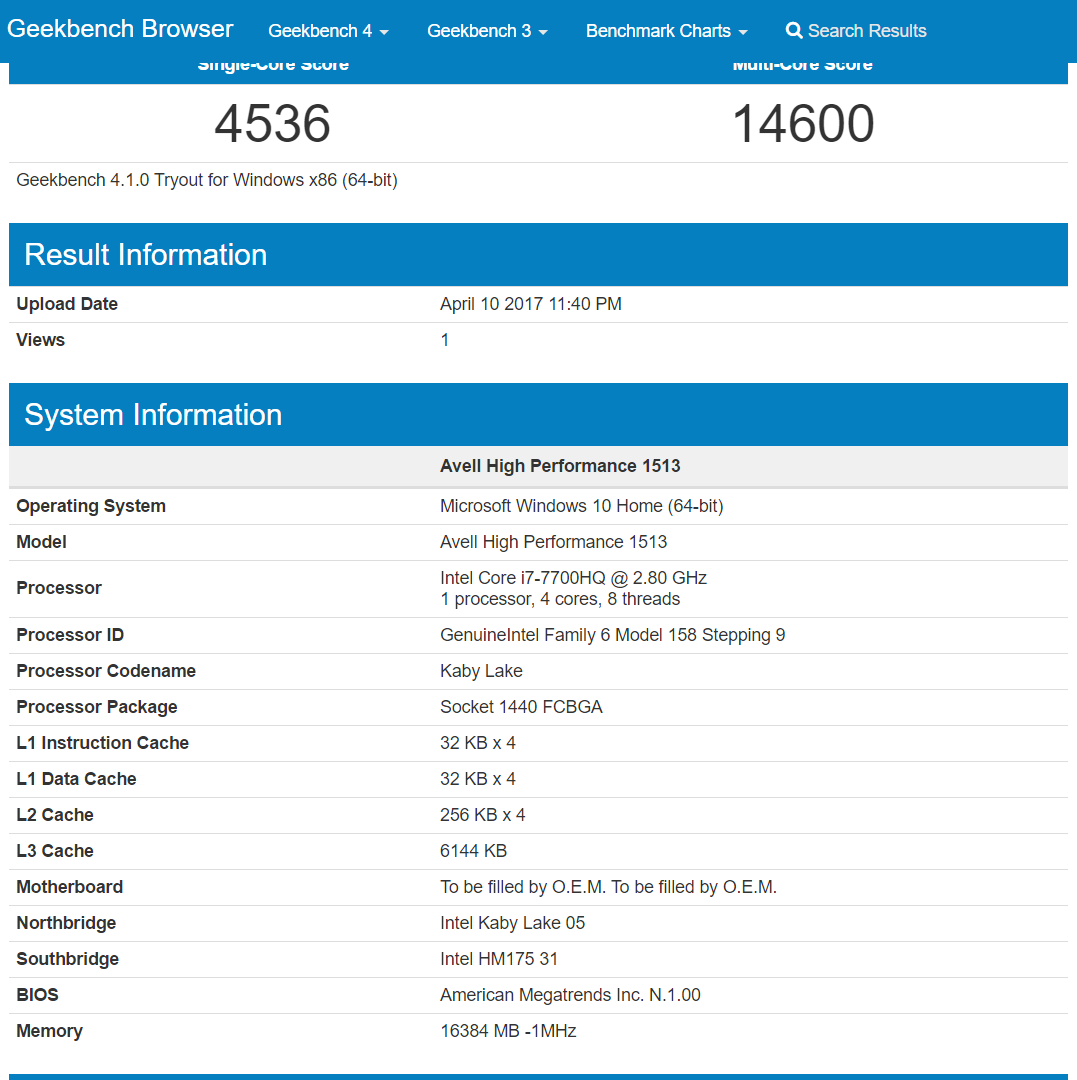

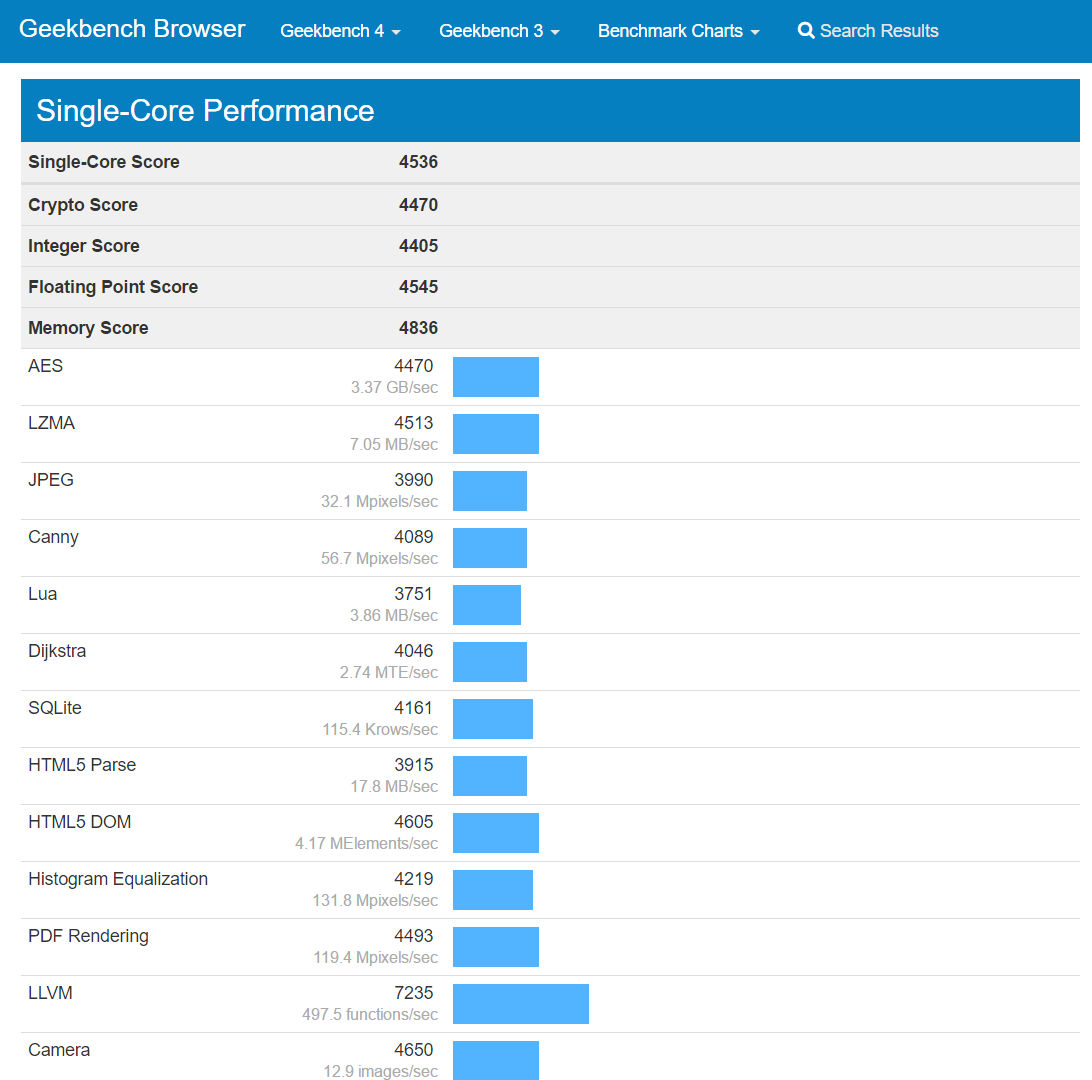

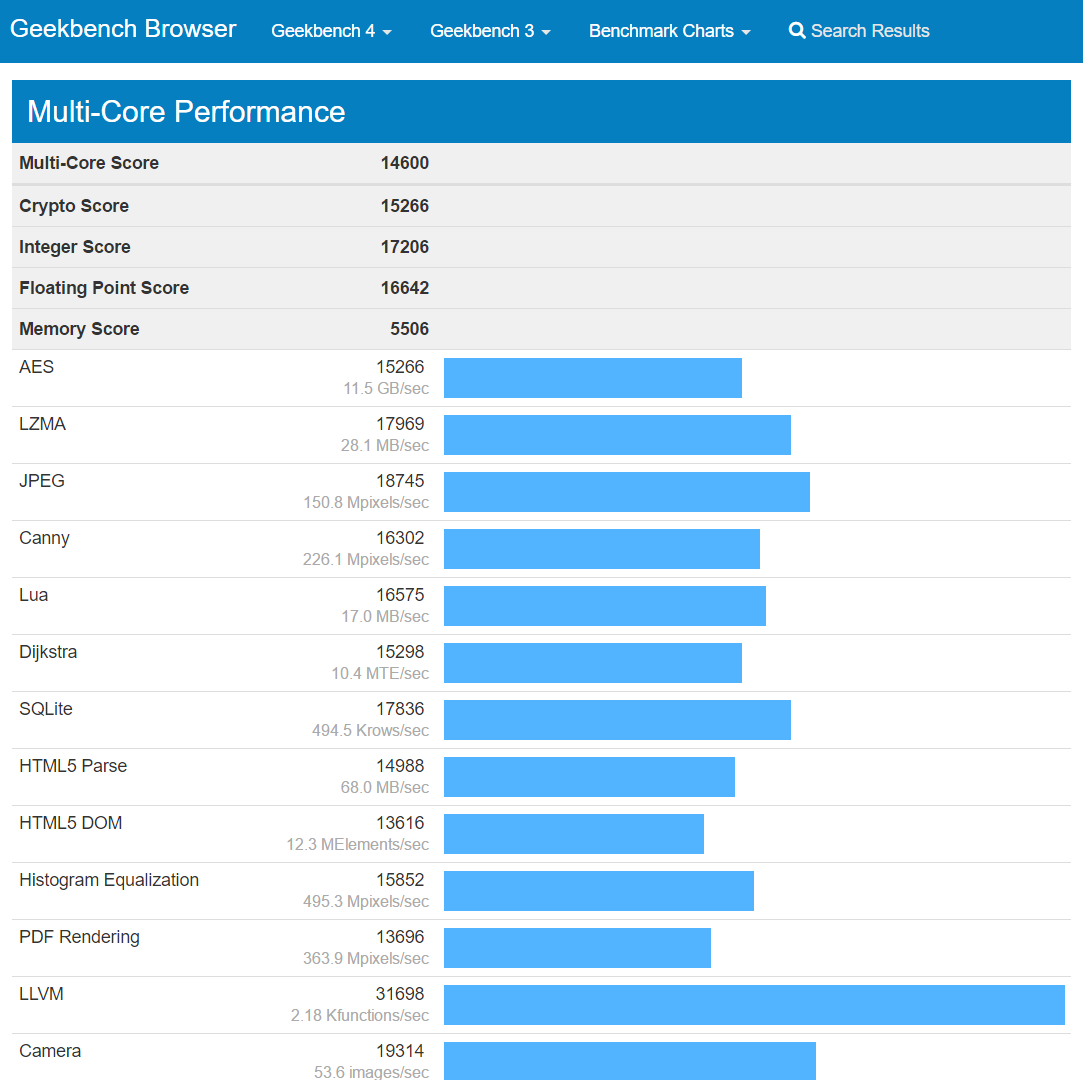

Benchmarks mostram mais do que o desempenho bruto de uma máquina. Capacidade de lidar com filtros e efeitos, estabilidade, consistência e controle de temperatura são igualmente medidos, já que pouco adianta contar com uma máquina potente se ela não é capaz de rodar bem nas mais variadas situações. O Titanium G1513 IRON V4 passou por todos eles sem problemas, além de contar com altíssima estabilidade dentro de uma faixa de temperatura segura. Na segunda parte deste artigo analisaremos ferramentas diferentes, capazes de oferecer relatórios detalhados do potencial da máquina.

Para saber mais:

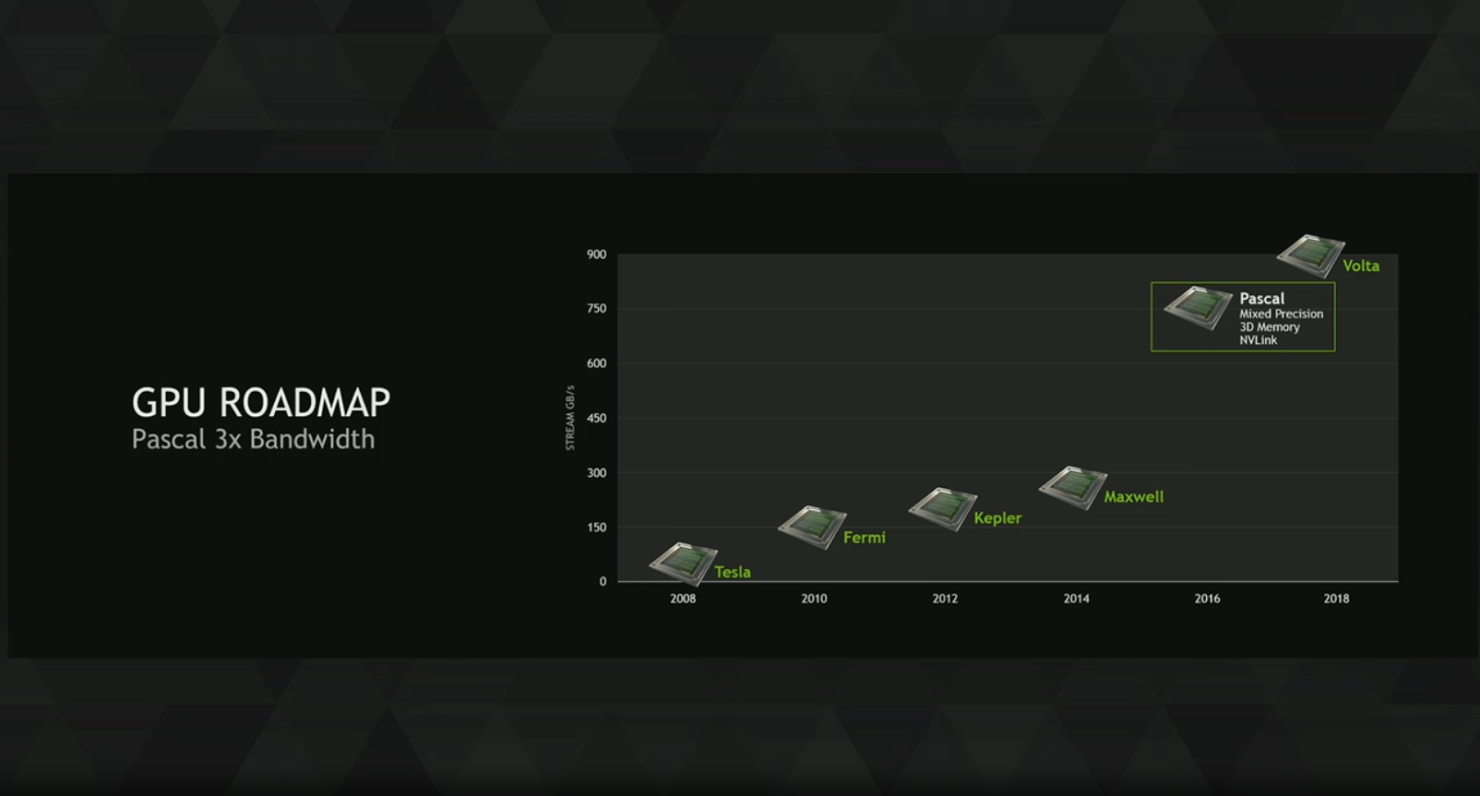

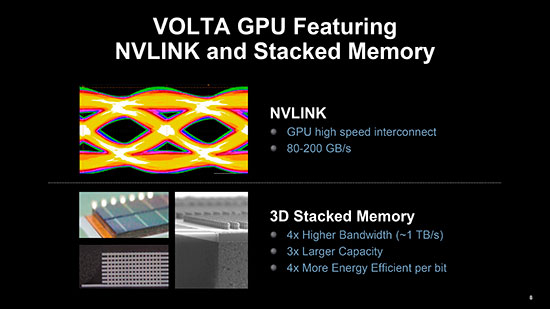

- Conheça a série 10 de placas de vídeo NVIDIA

- Tecnologias NVIDIA focadas na experiência dos gamers (Parte 1)

- Tecnologias NVIDIA focadas na experiência dos gamers (Parte 2)

- Notebook comum e notebook gamer. Qual a diferença?

Fontes: MAXON, UNIGINE 1 e 2, NotebookCheck, TechRadar, Ozone 3D

O post Entenda como funcionam os benchmarks de GPU (parte 1) apareceu primeiro em Notebooks Avell.

![A Queda No Impossível escrita por GeminiNoBea [Livre]](http://static.fanfiction.com.br/userfiles/8/A/7/4/C/F/21e0c7bc_1751421788.jpg)